AI春晚GTC開幕,皮衣老黃再次燃爆全場。

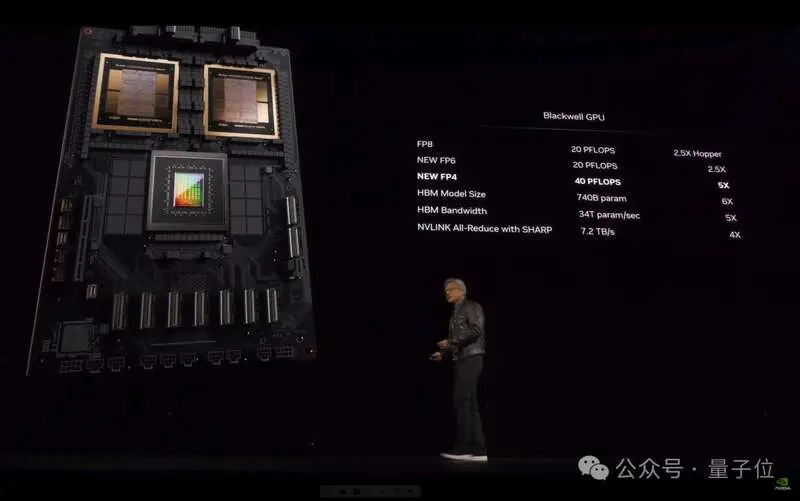

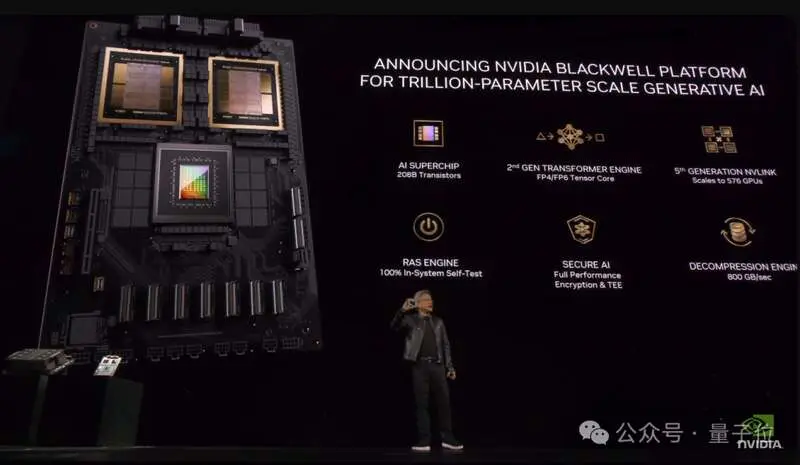

時隔兩年,英偉達官宣新一代Blackwell架構,定位直指「新工業革命的引擎」,「把AI擴展到萬億參數」。

作為架構更新大年,本次大會亮點頗多:

宣佈GPU新核彈B200,超級晶片GB200Blackwell架構新伺服器,一個機櫃頂一個超算推出AI推理微服務NIM,要做世界AI的入口新光刻技術cuLitho進駐台積電,改進產能。

……

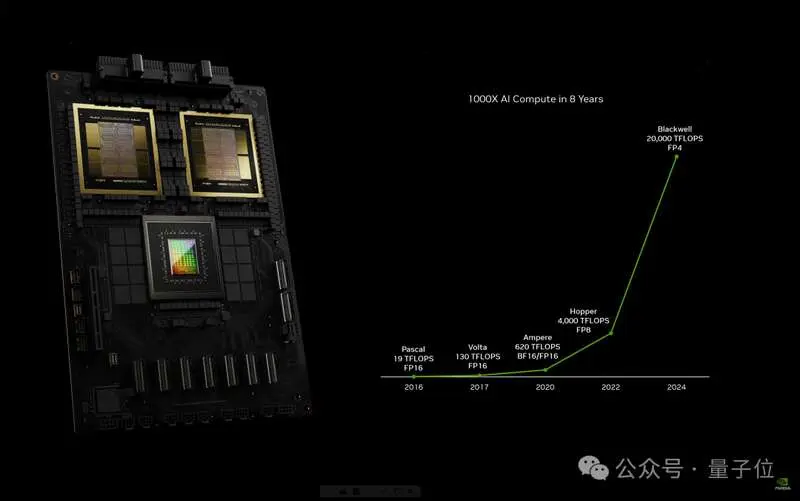

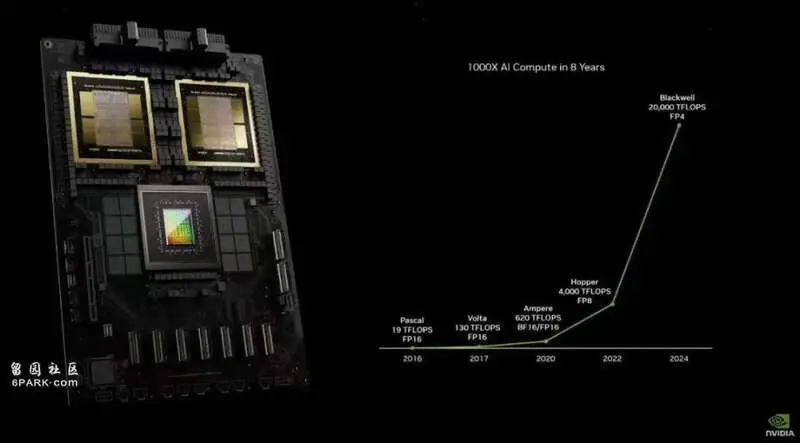

8年時間,AI算力已增長1000倍。

老黃斷言「加速計算到達了臨界點,通用計算已經過時了」。

我們需要另一種方式來進行計算,這樣我們才能夠繼續擴展,這樣我們才能夠繼續降低計算成本,這樣我們才能夠繼續進行越來越多的計算。

老黃這次主題演講題目為《見證AI的變革時刻》,但不得不說,英偉達才是最大的變革本革。

GPU的形態已徹底改變我們需要更大的GPU,如果不能更大,就把更多GPU組合在一起,變成更大的虛擬GPU。

Blackwell新架構硬件產品線都圍繞這一句話展開。

通過晶片,與晶片間的連接技術,一步步構建出大型AI超算集群。

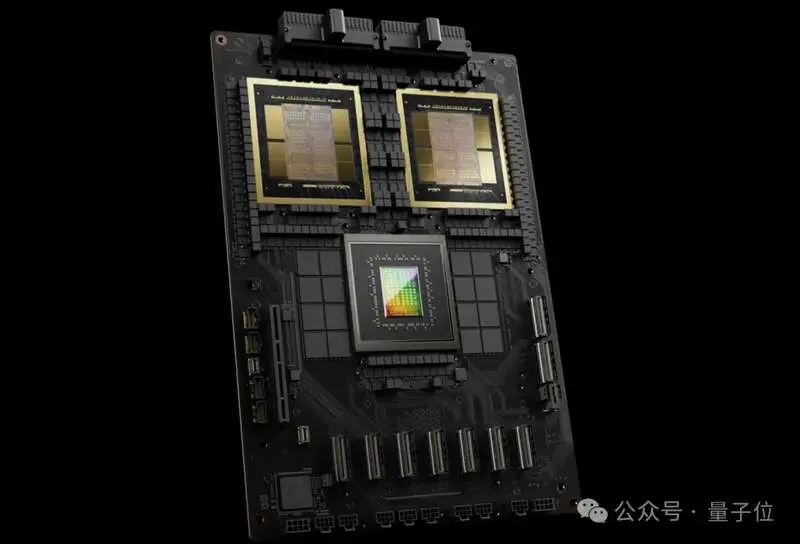

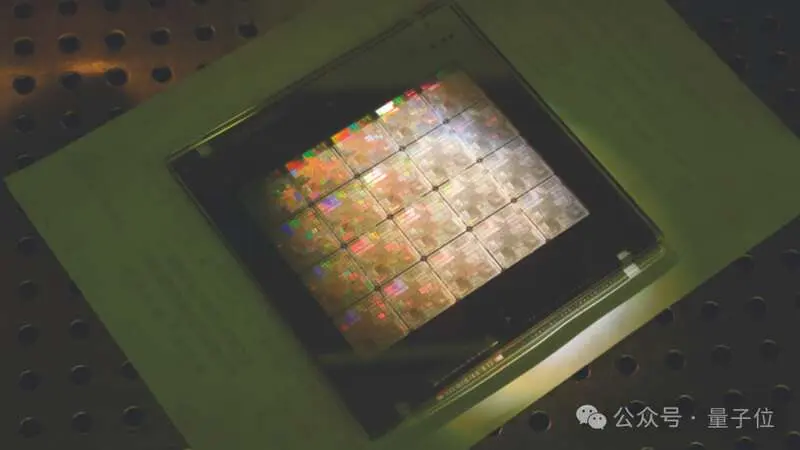

4nm製程達到瓶頸,就把兩個晶片合在一起,以10TB每秒的滿血帶寬互聯,組成B200 GPU,總計包含2080億電晶體。

沒錯,B100型號被跳過了,直接發佈的首個GPU就是B200。

兩個B200 GPU與Grace CPU結合就成為GB200超級晶片,通過900GB/s的超低功耗NVLink晶片間互連技術連接在一起。

兩個超級晶片裝到主板上,成為一個Blackwell計算節點。

18個這樣的計算節點共有36CPU+72GPU,組成更大的「虛擬GPU」。

它們之間由今天宣佈的NVIDIA Quantum-X800 InfiniBand和Spectrum™-X800以太網平台連接,可提供速度高達800Gb/s的網絡。

在NVLink Switch支持下,最終成為「新一代計算單元」GB200 NVL72。

一個像這樣的「計算單元」機櫃,FP8精度的訓練算力就高達720PFlops,直逼H100時代一個DGX SuperPod超級計算機集群(1000 PFlops)。

與相同數量的72個H100相比,GB200 NVL72對於大模型推理性能提升高達30倍,成本和能耗降低高達25倍。

把GB200 NVL72當做單個GPU使用,具有1.4EFlops的AI推理算力和30TB高速內存。

再用Quantum InfiniBand交換機連接,配合散熱系統組成新一代DGX SuperPod集群。

DGX GB200 SuperPod採用新型高效液冷機架規模架構,標準配置可在FP4精度下提供11.5 Exaflops算力和240TB高速內存。

此外還支持增加額外的機架擴展性能。

最終成為包含32000 GPU的分佈式超算集群。

老黃直言,「英偉達DGX AI超級計算機,就是AI工業革命的工廠」。

將提供無與倫比的規模、可靠性,具有智能管理和全棧彈性,以確保不斷的使用。

在演講中,老黃還特別提到2016年贈送OpenAI的DGX-1,那也是史上第一次8塊GPU連在一起組成一個超級計算機。

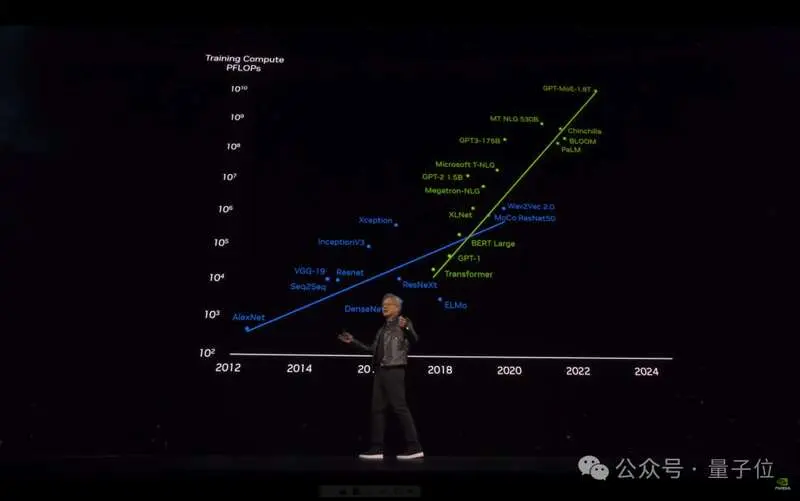

從此之後便開啟了訓練最大模型所需算力每6個月翻一倍的增長之路。

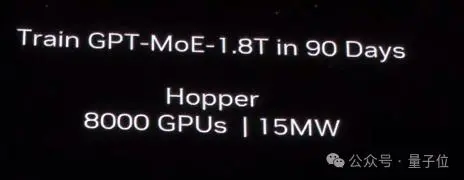

GPU新核彈GB200過去,在90天內訓練一個1.8萬億參數的MoE架構GPT模型,需要8000個Hopper架構GPU,15兆瓦功率。

如今,同樣給90天時間,在Blackwell架構下只需要2000個GPU,以及1/4的能源消耗。

在標準的1750億參數GPT-3基準測試中,GB200的性能是H100的7倍,提供的訓練算力是H100的4倍。

Blackwell架構除了晶片本身外,還包含多項重大革新:

第二代Transformer引擎動態為神經網絡中的每個神經元啟用FP6和FP4精度支持。

第五代NVLink高速互聯為每個GPU提供了1.8TB/s雙向吞吐量,確保多達576個GPU之間的無縫高速通信。

Ras Engine(可靠性、可用性和可維護性引擎)基於AI的預防性維護來運行診斷和預測可靠性問題。

Secure AI先進的加密計算功能,在不影響性能的情況下保護AI模型和客戶數據,對於醫療保健和金融服務等私隱敏感行業至關重要。

專用解壓縮引擎支持最新格式,加速數據庫查詢,以提供數據分析和數據科學的最高性能。

在這些技術支持下,一個GB200 NVL72就最高支持27萬億參數的模型。

而GPT-4根據泄露數據,也不過只有1.7萬億參數。

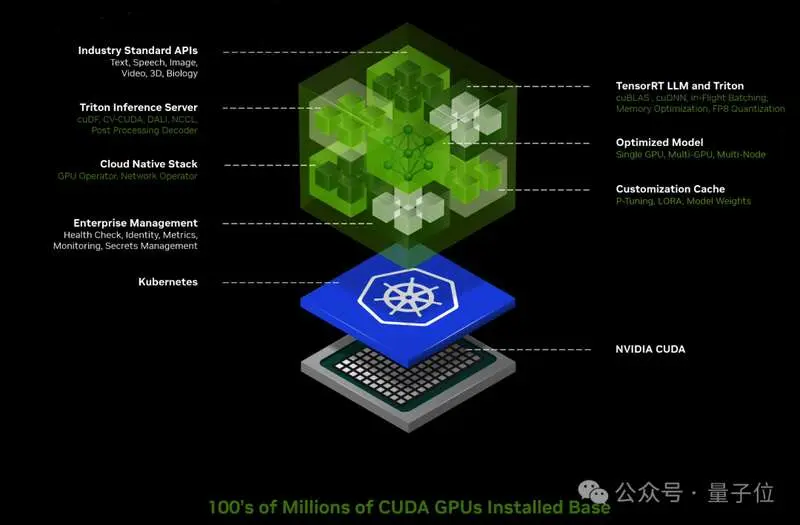

英偉達要做世界AI的入口老黃官宣ai.nvidia.com頁面,要做世界AI的入口。

任何人都可以通過易於使用的用戶界面體驗各種AI模型和應用。

同時,企業使用這些服務在自己的平台上創建和部署自定義應用,同時保留對其知識產權的完全所有權和控制權。

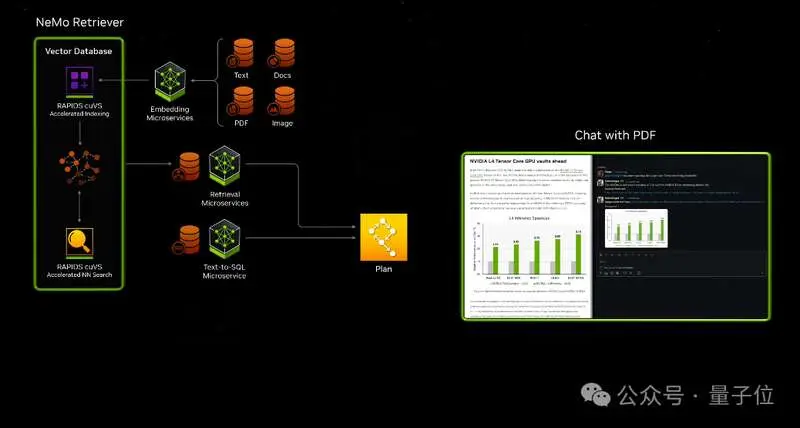

這上面的應用都由英偉達全新推出的AI推理微服務NIM支持,可對來自英偉達及合作夥伴的數十個AI模型進行優化推理。

此外,英偉達自己的開發套件、軟件庫和工具包都可以作為NVIDIA CUDA-X™微服務訪問,用於檢索增強生成(RAG)、護欄、數據處理、HPC等。

比如通過這些微服務,可以輕鬆構建基於大模型和向量數據庫的ChatPDF產品,甚至智能體Agent應用。

NIM微服務定價非常直觀,「一個GPU一小時一美元」,或年付打五折,一個GPU一年4500美元。

從此,英偉達NIM和CUDA做為中間樞紐,連接了百萬開發者與上億GPU晶片。

什麼概念?

老黃曬出AI界「最強朋友圈」,包括亞馬遜、迪士尼、三星等大型企業,都已成為英偉達合作夥伴。

最後總結一下,與往年相比英偉達2024年戰略更聚焦AI,而且產品更有針對性。

比如第五代NVLink還特意為MoE架構大模型優化通訊瓶頸。

新的晶片和軟件服務,都在不斷的強調推理算力,要進一步打開AI應用部署市場。

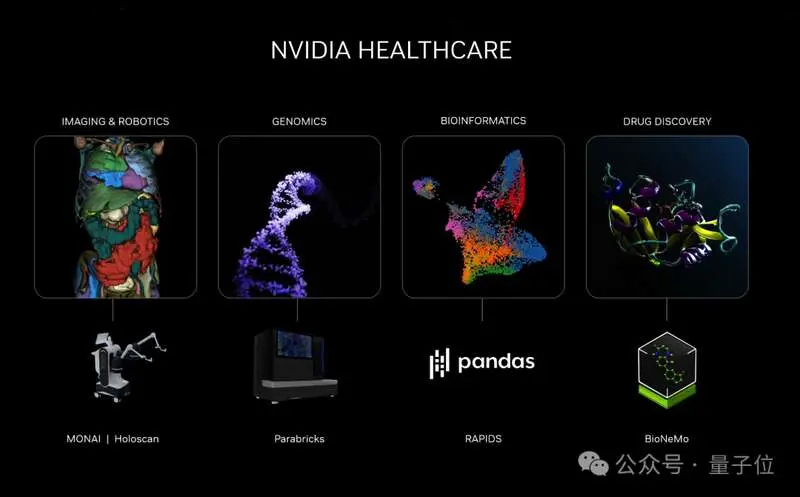

當然作為算力之王,AI並不是英偉達的全部。

這次大會上,還特別宣佈了與蘋果在Vision Pro方面的合作,讓開發者在工業元宇宙里搞空間計算。

此前推出的新光刻技術cuLitho軟件庫也有了新進展,被台積電和新思科技採用,把觸手伸向更上游的晶片製造商。

當然也少不了生物醫療、工業元宇宙、機械人汽車的新成果。

以及佈局下一輪計算變革的前沿領域,英偉達推出雲量子計算機模擬微服務,讓全球科學家都能充分利用量子計算的力量,將自己的想法變成現。

One More Thing

去年GTC大會上,老黃與OpenAI首席科學家Ilya Sutskever的爐邊對談,仍為人津津樂道。

當時世界還沒完全從ChatGPT的震撼中清醒過來,OpenAI是整個行業絕對的主角。

如今Ilya不知蹤影,OpenAI的市場統治力也開始鬆動。在這個節骨眼上,有資格與老黃對談的人換成了8位——

Transformer八子,開山論文《Attention is all you need》的八位作者。

他們陸陸續續已經悉數離開谷歌,其中7位投身AI創業,有模型層也有應用層,有toB也有toC。

這八位傳奇人物既象徵着大模型技術真正的起源,又代表着現在百花齊放的AI產業圖景。在這樣的格局中,OpenAI不過是其中一位玩家。

而就在兩天後,老黃將把他們聚齊,在自己的主場。

要論在整個AI界的影響力、號召力,在這一刻,無論是「鋼鐵俠」馬斯克還是「奧特曼」Sam Altman,恐怕都比不過眼前這位「皮衣客」黃仁勛。

……

直播回放:

https://

算力增長千倍,英偉達為華爾街再續一命

時隔5年,英偉達GTC大會再次恢復線下舉行。隨着各類Al大模型的推出及落地應用的加速,GTC已經被業界看成「AI風向標」,英偉達創始人兼CEO黃仁勛的主題演講、市場對各類新品的預期都會影響美股AI概念股股價的走勢。

黃仁勛在2024年GTC大會演講主題為《見證AI的變革時刻》,其提到亮點包括新的架構Blackwell、新的硬件產品GB200及人型機械人項目等最新突破性成果。

整體而言,英偉達發佈的基於Blackwell架構的B200晶片浮點運算能力是H100的5倍,這意味着科技巨頭採購相同計算能力所需的晶片數量會減少。

在目前大部分AI大模型落地前景尚不明朗的情況下,B200晶片的出現能大幅提升AGI創業公司的算力,加速AGI通用人工智能進程,同時降低算力運行中的能耗成本。

黃仁勛:英偉達要成為AI軟件的「晶圓廠」

過去一年,受AIGC熱潮的影響,英偉達的總市值翻了4倍多。英偉達股價大漲的催化劑是Open AI於2022年年底推出的ChatGPT。在展示英偉達發展史時,黃仁勛又一次提到其將首台DGX-1送給OpenAI的故事。

2016年4月,英偉達在矽谷發佈深度學習超級計算機DGX-1,搭載了8塊P100 GPU。儘管當時DGX-1已經收到了近100家公司的訂單,黃仁勛卻把第一台捐給了OpenAI,這極大縮短了OpenAI訓練對話和生成式模型的周期。

「隨着transformer模型被發明,我們能以驚人的速度擴展大型語言模型,每六個月就能翻一番。而為了訓練這些越來越大的模型,我們也需要更強的算力。」黃仁勛說。

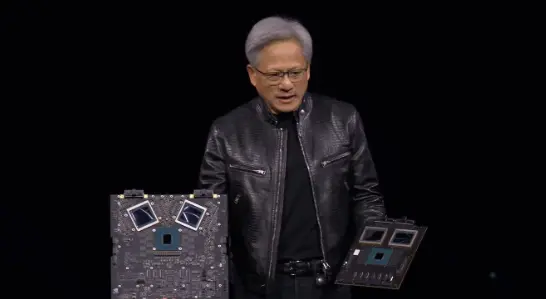

緊接着黃仁勛亮出了新一代晶片解決方案Blackwell及首款基於Blackwell的AI加速卡GB200。

黃仁勛現場將Blackwell架構和Grace Hopper架構的性能進行對比。前一代GPU「Hopper」H100採用4nm工藝,集成電晶體800億,而同樣採用台積電4NP工藝的Blackwell擁有2080億個電晶體。

一般而言,在同一製程及類似的微架構下,電晶體的數量越多,其處理複雜邏輯和並行計算的能力越強。這意味着Blackwell架構的計算和推理能力比上一代更強。

此外,基於Blackwell的處理器,B200AI性能為每秒20千萬億次浮點運算,而此前最強的H100為每秒4千萬億次浮點運算,約是其5倍。

AI晶片的浮點運算能力越強意味着其在處理涉及大量浮點計算的任務(例如科學計算、機器學習、圖形渲染等)時效率更高,這不僅可以節省訓練的時間成本,也能節省電力等能耗成本。

「如果要訓練一個1.8萬億參數量的GPT模型,需要8000張Hopper GPU,消耗15兆瓦的電力,連續跑上90天。但如果使用Blackwell GPU,只需要2000張,同樣跑90天只要消耗四分之一的電力。當然不只是訓練,生成Token的成本也會隨之降低。」黃仁勛舉例說。

近八年來,AI算力增長了一千倍

NVIDIA Blackwell架構的生成式AI引擎,以及更快的NVIDIA NVLink互連和增強的安全功能,將數據中心推向了一個新時代。微軟Azure、亞馬遜AWS、谷歌雲、聯想等一眾科技巨頭都是Blackwell架構的首批用戶。

此後,黃仁勛宣佈新的AI微服務——NIM軟件,用於開發和部署企業級生成式AI應用。黃仁勛表示,與現在靠代碼開發軟件不同,未來可能就要靠一堆NIMs(Nvidia inference micro service),用與AI聊天的形式調動一堆NIMS來完成訓練、應用的部署。英偉達的願景是成為AI軟件的「晶圓廠」。

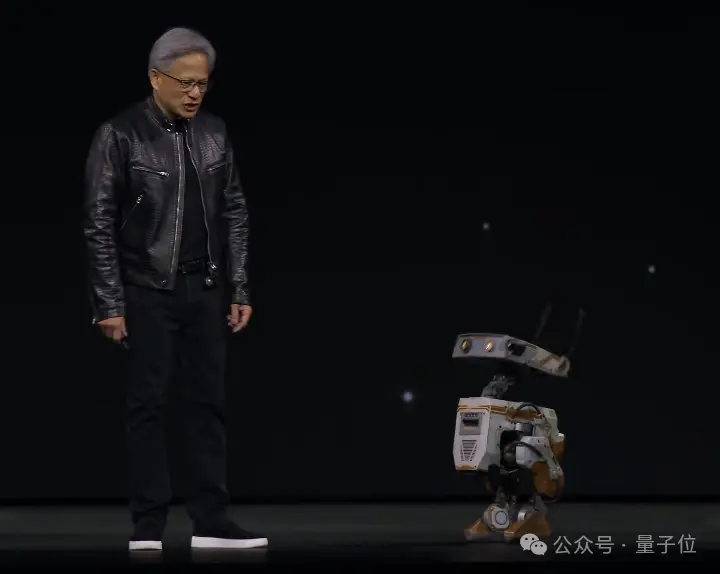

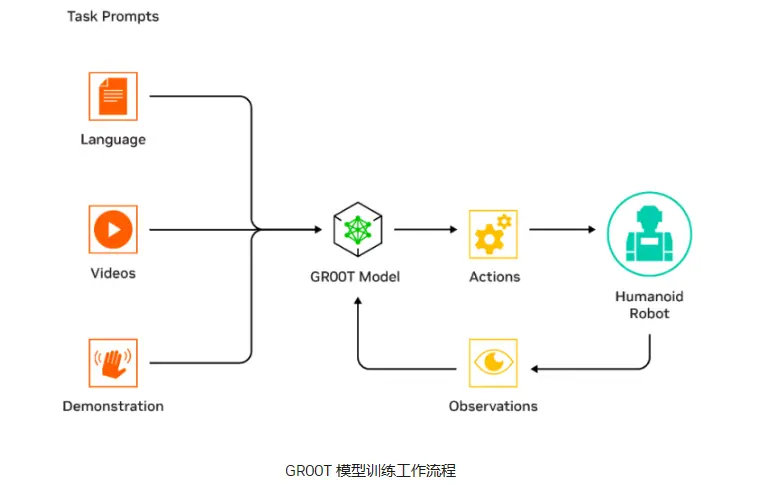

此外,黃仁勛還在現場重點介紹了人型機械人項目——Project GR00T。GR00T是一個通用基礎模型,有望改變模擬人形機械人學習方式。GR00T經過 NVIDIA GPU加速模擬訓練,使人形機械人能夠通過模仿和觀察人類動作來進行強化學習。GR00T模型將多模態指令和過去的交互作為輸入,並生成機械人執行的動作。

據了解,英偉達目前正在構建包括NVIDIA IAI、Omniverse、ISAAC三大平台,三大平台均與機械人產業高度關聯。

為AI概念續了一命

受蘋果和谷歌合作消息、以及英偉達發佈AI新品的影響,美股三大指數集體收漲。截至3月18日美股收盤,納指漲0.82%。從個股看,7大科技公司股價都不同幅度上漲。其中,特斯拉漲幅6.25%,谷歌-A漲幅4.6%,微軟漲幅0.22%,meta漲幅2.66%,亞馬遜漲幅0.03%,蘋果漲幅0.64%,英偉達漲幅0.7%。

從消息側看,特斯拉一天漲幅高達6.25%,或與其宣佈在歐洲提高Model Y價格相關。近日,特斯拉宣佈,將從4月1日起將北美市場的Model Y車型售價「再次上漲1000美元」。這將是特斯拉 Model Y一個月內在當地的第二次提價。

蘋果股價也結束了連續兩周的陰跌,昨晚漲幅0.64%,這與谷歌合作、黃仁勛宣佈「NVIDIA Omniverse Cloud將可以連接到蘋果公司混合頭顯Vision Pro」相關。

因為AGI晶片投入成本高昂、落地前景不明,美股AI概念近期陷入疲軟。

昨夜,英偉達或許再次給曾斥巨資購買H100的科技巨頭們」續了一命」。比如,Meta在2023年買了超過15萬塊 NVIDIA GPU,2024年 Meta預計將購買超過35萬塊英偉達 H100 GPU(據Omdia數據)。現在,B200的浮點運算能力是H100的5倍,這意味,科技巨頭採購相同計算能力所需的晶片數量減少。

當然前期是,B200的價格不會比H100高很多。黃仁勛並沒有在現場公佈B200的價格,僅表示其將於今年晚些時候上市。

在H100等晶片取得巨大成功後,英偉達股價從去年開始節節攀升,但這種攀升在最近兩周出現動盪。上周五英偉達收盤報878.365美元/股,較高點跌去10%。

而曾斥巨資購買英偉達AI晶片的科技巨頭們也開始考略AI服務能帶來多少現實收益。

亞馬遜行政總裁Andy Jassy曾多次向投資者表示,生成式AI將為亞馬遜帶來數十億美元的收益。然而,面對目前的技術實際應用與預期之間的差距,他也坦承,這項技術當前的直接收益「相對較小」。

英偉達代表的AI概念能否持續為美股續命還是未知數。最關鍵之戰,還在於OpenAI、微軟、谷歌、Meta等巨頭能否早日將算力投入轉化為商業收入。