最近一段時間,公眾開始注意到,當前蓬勃發展的生成式AI技術需要耗費大量的電力。

據《紐約客》當地時間9日報道,荷蘭國家銀行數據專家Alex de Vries估計,OpenAI旗下聊天機械人ChatGPT每天消耗超過50萬千瓦時的電力,用於處理約2億個用戶請求,相當於美國家庭每天用電量的1.7萬多倍。

谷歌的搜尋引擎同樣需要大量的電力。

據de Vries估計,若谷歌在每次搜索中都使用AIGC(生成式人工智能技術),其年耗電量將增至約290億千瓦時,這一數字超過了許多國家的一年用電量,包括肯雅、危地馬拉和克羅地亞。

而隨着AI晶片的不斷更新換代,其所需的電力也越來越多。

比如,據戴爾公司首席運營官Jeff Clarke近日透露,英偉達將於2025年推出載有「Blackwell」架構的B200產品,功耗或將達到1000W,較H100增加40%以上。

媒體的曝光在一定程度上呼應了一些AI大佬近的擔憂。

AI大佬集體發聲:太缺電了!

前不久馬斯克在接受媒體採訪時預言,AI行業經歷將在明年迎來電力短缺,屆時將「沒有足夠的電力來運行所有的晶片」。

很容易預測,接下來短缺的會是降壓變壓器。

你得給這些晶片供電。如果你的電力供應輸出是100到300千伏,而它必須一路降壓到0.6伏,這是一個很大的降壓過程。

OpenAI創始人Sam Altman在世界經濟論壇上也表示:

我們需要的能源確實比我們之前想像的要多得多。

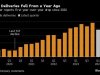

隨着生成式AI技術的快速蔓延,晶片對電力的需求大幅飆升。相關數據顯示,十年前全球數據中心市場的耗電量為100億瓦,而如今1000億瓦的水平已十分常見。

另外,根據美國Uptime Institute的預測,到2025年,人工智能業務在全球數據中心用電量中的佔比將從2%猛增到10%。

按照當前的趨勢,de Vries預計,到2027年整個AI行業每年將消耗85-134太瓦時(1太瓦時=10億千瓦時)的電力。

de Vries表示,他對於人們在面對大量機器學習的同時,人類學習的缺失感到失望。

在我看來,從政策角度講,短期到中期內,唯一現實的措施是要求企業披露(用電數據)。

加密貨幣領域耗費了相當長的時間才達到這一點,而人工智能沒有能更早做到這一點,讓我感到失望。

根據de Vries此前編制的比特幣能耗指數,比特幣挖礦如今每年消耗1450億千瓦時的電力,這一數字比整個荷蘭的年用電量還要多,發電導致的二氧化碳排放量達8100萬噸,超過了如摩洛哥等國的年排放總量。

AI電力需求飆升之際,能源賽道迎來新一輪機會?

有策略師分析表示,AI技術發展利好能源資產:

越來越多的人開始意識到,大型人工智能伺服器群將需要大量能源,這正在提高一些投資者的興趣,開始將投資範圍擴大至電力、油氣在內的相關能源領域,核能也開始受到關注。

英偉達CEO黃仁勛在最近的一場公開演講中明確表示:

AI的盡頭是光伏和儲能!如果只考慮計算機,我們需要燒掉14個地球的能源。

Altman也發表了類似觀點:

未來AI的技術取決於能源,我們需要更多的光伏和儲能。

我們需要的是核聚變,或者是大規模的、成本極低的太陽能加儲能系統,規模之大前所未有。

挑戰同樣存在!

以美國為例,清潔能源、AI、數據中心、電動汽車、挖礦等多種產業的增長,讓原本陷入停滯的美國電力需求再度「起飛」。但即使被譽為世界上「最大的機器」,美國電網也似乎無法應對這突如其來的變化。

有分析師指出,美國70%的電網接入和輸配電設施已老化,某些地區電網傳輸線路不足。因此,美國電網需要大規模升級,如果不採取行動,到2030年美國將面臨一道難以逾越的國內供應缺口。