哪怕只有幾十個神經元,AI也能出現泛化能力!

這是幾個谷歌科學家在搞正經研究時,「不經意間」發現的新成果。

他們給一些很簡單的AI模型「照了個X光」——將它們的訓練過程可視化後,發現了有意思的現象:

隨着訓練時間增加,一些AI會從「死記硬背」的狀態中脫離出來,進化出「領悟力」(grokking),對沒見過的數據表現出概括能力。

這正是AI掌握泛化能力的關鍵。

基於此,幾位科學家專門寫了個博客,探討了其中的原理,並表示他們會繼續研究,試圖弄清楚大模型突然出現強理解力的真正原因。

一起來看看。

並非所有AI都能學會「領悟」

科學家們先探討了AI出現「領悟力」(grokking)的過程和契機,發現了兩個現象:

一、雖然訓練時loss會突然下降,但「領悟」並不是突然發生的,它是一個平滑的變化過程。

二、並非所有AI都能學會「領悟」。

先來看第一個結論。他們設計了一個單層MLP,訓練它完成「數奇數」任務。

「數奇數」任務,指識別一串長達30位「0」「1」序列中的前3位是否有奇數個「1」。例如,在

000110010110001010111001001011中,前3位沒有奇數個1;010110010110001010111001001011中,前3位有奇數個1。

在訓練前期階段,模型中各神經元的權重(下圖中的熱圖)是雜亂無章的,因為AI不知道完成這一任務只需要看前3個數字。

但經過一段時間的訓練後,AI突然「領悟了」,學會了只看序列中的前3個數字。具體到模型中,表現為只剩下幾個權重會隨着輸入發生變化:

這個訓練過程的目標被稱之為最小化損失(提升模型輸出準確率),採用的技術則被稱之為權重衰減(防止模型過擬合)。

訓練過程中,有一些權重與任務的「干擾數字」(30位序列的後27位)相關,下圖可視化為灰色;有一些則與完成任務的「前3位數字」有關,下圖可視化為綠色。

當最後一個灰色權重降到接近0,模型就會出現「領悟力」,顯然這個過程不是突然發生的。

再來看第二個結論。不是所有AI模型都能學會「領悟」。

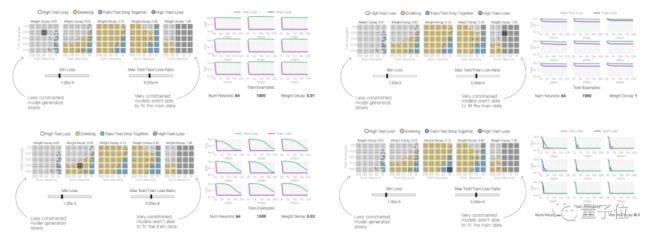

科學家們訓練了1125個模型,其中模型之間的超參數不同,每組超參數訓練9個模型。

最後歸納出4類模型,只有2類模型會出現「領悟力」。

如下圖,「白色」和「灰色」代表學不會「領悟」的AI模型,「黃色」和「藍色」代表能「領悟」的AI模型。

總結概括規律就是,一旦權重衰減、模型大小、數據量和超參數的設置不合適,AI的「領悟力」就有可能消失——

以權重衰減為例。如果權重衰減太小,會導致模型過擬合;權重衰減太大,又會導致模型學不到任何東西。

嗯,調參是門技術活……

了解現象之後,還需要探明背後的原因。

接下來,科學家們又設計了兩個小AI模型,用它來探索模型出現「領悟力」、最終掌握泛化能力出現的機制。

更大的模型學會泛化的機制

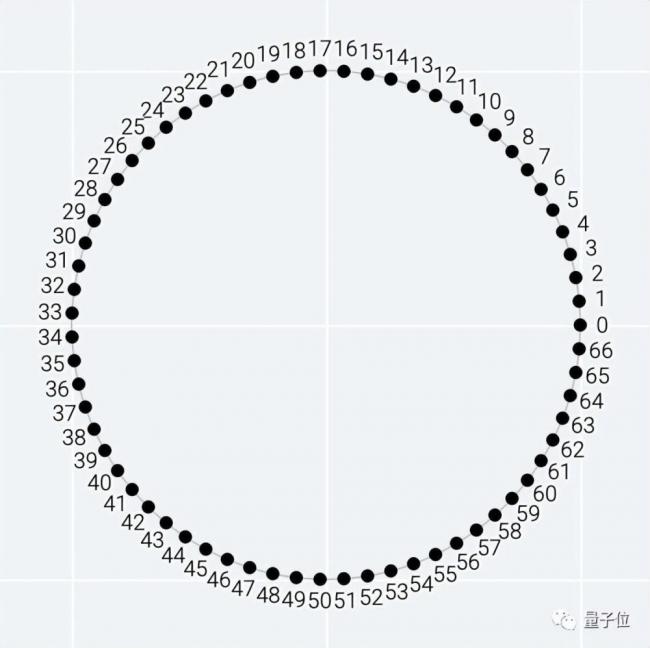

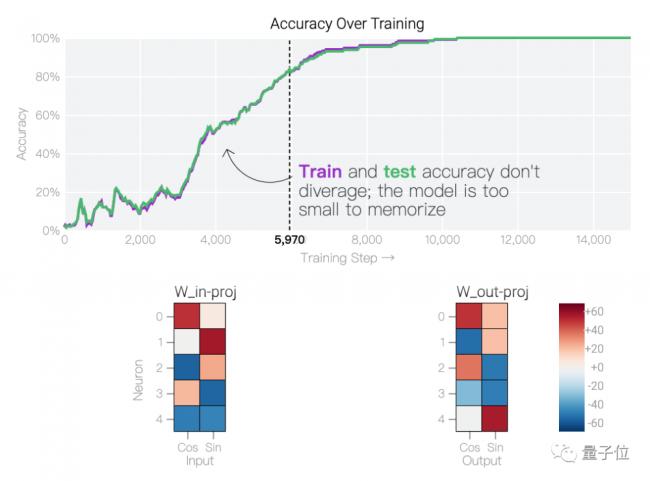

科學家們分別設計了一個24個神經元的單層MLP和一個5個神經元的單層MLP,訓練它們學會做模加法(modular addition)任務。

模加法,指(a + b) mod n。輸入整數a和b,用它們的和減去模數n,直到獲得一個比n小的整數,確保輸出位於0~(n-1)之間。

顯然,這個任務的輸出是周期性的,答案一定位於0~66之間。

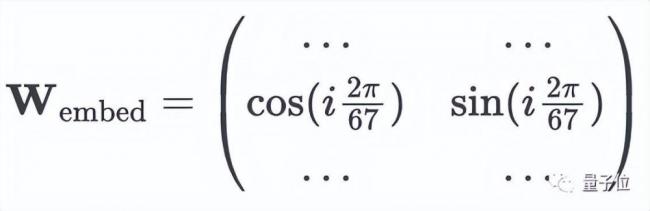

首先,給只有5個神經元的單層MLP一點「提示」,設置權重時就加入周期性(sin、cos函數)。

在人為幫助下,模型在訓練時擬合得很好,很快學會了模加法。

然後,試着「從頭訓練」具有24個神經元的單層MLP,不特別設置任何權重。

可以看到,訓練前期,這隻MLP模型的權重(下面的熱圖)變化還是雜亂無章的:

然而到達某個訓練階段後,模型權重變化會變得非常規律,甚至隨着輸入改變,呈現出某種周期性變化:

如果將單個神經元的權重拎出來看,隨着訓練步數的增加,這種變化更加明顯:

這也是AI從死記硬背轉變為具有泛化能力的關鍵現象:神經元權重隨着輸入出現周期性變化,意味着模型自己找到並學會了某種數學結構(sin、cos函數)。

這裏面的頻率(freq)不是固定的一個值,而是有好幾個。

之所以會用到多個頻率(freq),是因為24個神經元的單層MLP還自己學會了使用相長干涉(constructive interference),避免出現過擬合的情況。

不同的頻率組合,都能達到讓AI「領悟」的效果:

用離散傅里葉變換(DFT)對頻率進行隔離,可以發現和「數奇數」類似的現象,核心只有幾個權重起作用:

總結來看,就像前面提到的「數奇數」任務一樣,「模加法」實驗表明,參數量更大的AI也能在這個任務中學會「領悟」,而這個過程同樣用到了權重衰減。

從5個神經元到24個神經元,科學家們成功探索了更大的AI能學習「領悟」的機制。

接下來,他們還計劃將這種思路套用到更大的模型中,以至於最後能歸納出大模型具備強理解力的原因。

不僅如此,這一成果還有助於自動發現神經網絡學習算法,最終讓AI自己設計AI。

團隊介紹

撰寫博客的作者來自谷歌的People + AI Research(PAIR)團隊。

這是谷歌的一個多學科團隊,致力於通過基礎研究、構建工具、創建框架等方法,來研究AI的公平性、可靠性等。

一句話總結就是,讓「AI更好地造福於人」。