OpenAI出手了!為了不讓超級智能失控,首席科學家Ilya Sutskever和Jan Leike將共同領導團隊在未來4年投入20%算力,解決超智能AI對齊問題。

超級AI智能會殺死所有人!

Sam Altman曾多次公開表態對AI未來的擔憂,甚至自己都夜不能寐。

如今,OpenAI組建了一個團隊,試圖用20%算力,在未來4年解決「超級智能對齊問題」。

最新團隊將由聯合創始人兼首席科學家Ilya Sutskever和Jan Leike共同領導。

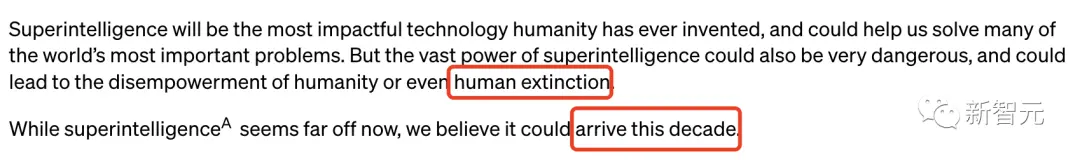

博客開篇,短短几行,遍闡述了OpenAI對超級智能降臨時間的預判,以及具有「毀天滅地」能力的重度擔憂。

超級智能將是人類發明的最具影響力的技術,可以幫助我們解決世界上許多最重要的問題。但超級智能的巨大力量也可能非常危險,並可能導致人類喪失權力,甚至導致人類滅絕。

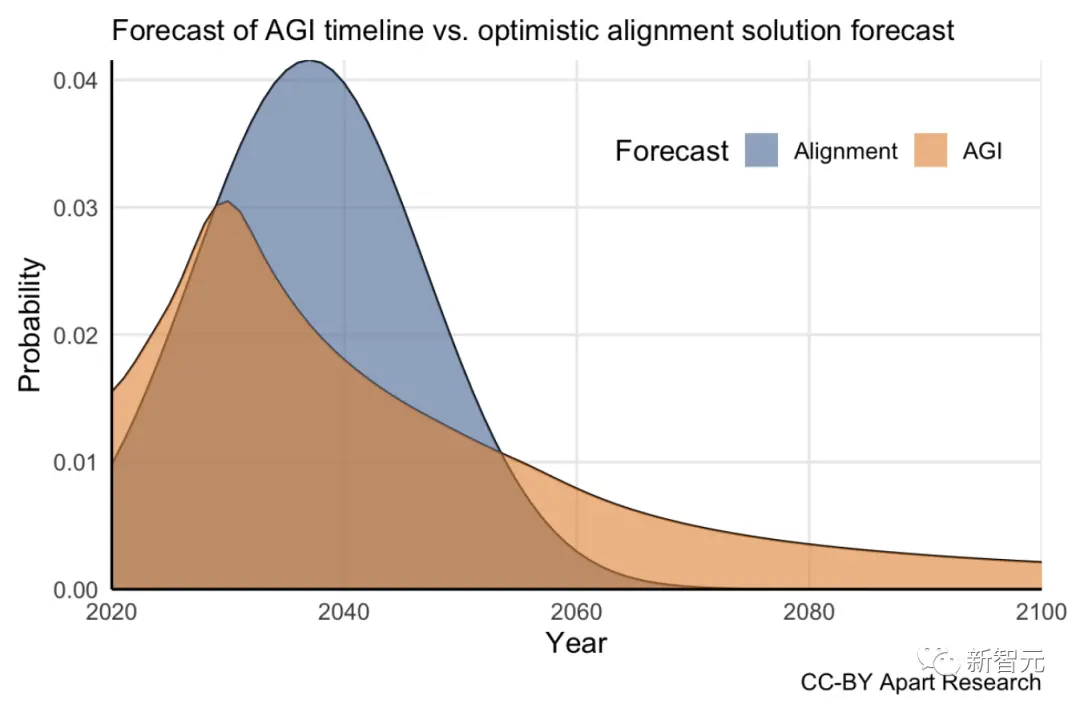

雖然有超級智能現在看來還很遙遠,我們相信這可能在十年內實現。

接下來4年,OpenAI要做的,就是防止超級智能殺死所有人類。

四年解決超級AI對齊問題

而Altman認為,想要管理這些風險,徹底解決對齊問題,就必須成立新的治理機構。

他表示,目前還沒有一個像樣的解決方案來引導或控制潛在的超級AI。

當前的技術,都依賴於人類的監督,比如根據人類反饋進行的強化學習(RLHF)等等。

但純靠人力來監督比我們聰明得多的AI系統,總有一天會費勁又吃力。而目前的對齊技術又無法擴展到超級智能,所以對新技術突破的需要就提上了日程。

Altman在今天還發起了「英雄榜」。

OpenAI的目標,就是建立一個大致擁有人類水平的自動對齊研究員,然後用大量計算擴展研究工作,疊代調整超級智能。

為了創建第一個「自動對齊研究員」,本質上講創建一個AI,OpenAI分三步走。

第一,開發一種可擴展的訓練方法;

第二,驗證生成的模型;

第三,對整個對齊管道進行壓力測試。

研究人員利用AI系統來協助評估其它AI系統(可擴展的監督),同時研究人員還希望了解並控制他們的模型是如何將監督推廣到人類研究員無法監督的任務上去的(有點繞嘴)。

之後,研究人員為了驗證系統的一致性,自動搜索了有問題的行為,以及存在問題的內部結構。

最後可以通過找到一個未對齊的模型來測試整個流程,確認開發的框架可以檢測到各種不同的未對齊類型(稱為對抗性測試)。

OpenAI的研究人員預計,隨着對這個問題的研究越來越深入,研究重點也會發生變化,甚至還可能會有新的研究領域出現。

全新團隊

為此,OpenAI正式宣佈,組建一個由頂級機器學習研究人員和工程師組成的團隊——「Superalignment」。

在接下來的四年裏,OpenAI將投入到目前為止獲得的計算資源中的20%,用於解決超級AI的對齊問題。

在這個過程中,預計將會有很多團隊參與進來,從開發新方法到將其擴展至實際應用。

OpenAI表示,自己的目標是在四年內解決超級智能對齊的核心技術挑戰。

雖然聽起來很大,實現起來也不一定100%成功,但OpenAI還是認為只要集多方努力,還是可以解決的。

Ilya Sutskever作為OpenAI的聯合創始人兼首席科學家,已經把這個目標當作其核心研究重點,並將與Jan Leike——對齊項目負責人,共同領導該團隊。

團隊成員包括此前負責對齊工作的研究人員和工程師,甚至還有其他團隊的研究人員,可謂陣容龐大。

LeCun所言「狗級」AI,真會十年翻身?

可以說,OpenAI對超級智能AI系統的將在十年內誕生,是一個非常大膽的預測。

首先,就拿ChatGPT來說,沒有人承認它是一個能夠進行人類思維的人工智能。

與之相反,ChatGPT作為一個類似於自動完成的大型語言模型,可以重新創建類似人類的反應,但沒有完全理解單詞背後的含義。

因此,有時候它會編造明顯錯誤,或無法理解基本邏輯的答案。

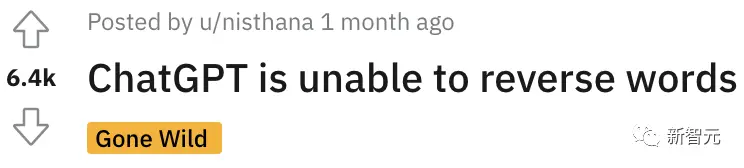

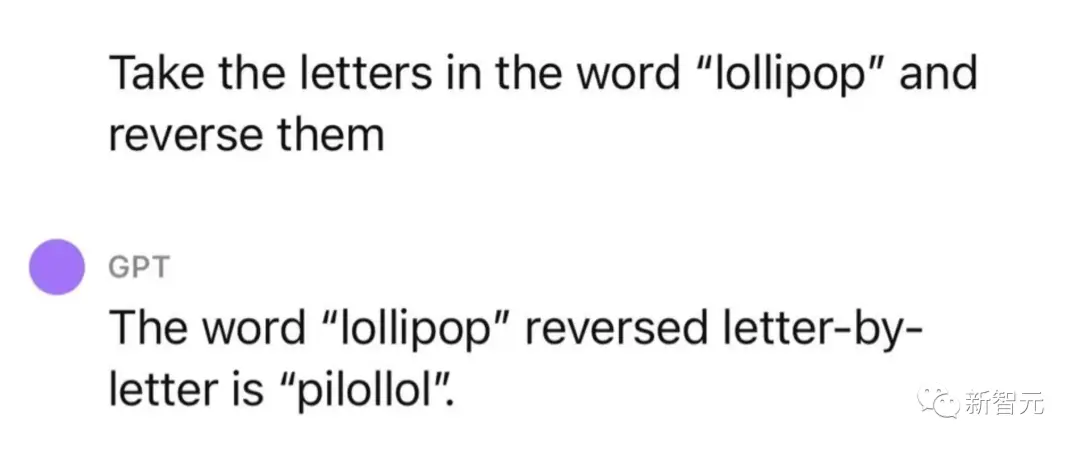

前段時間,吳恩達在新開的課程中指出,ChatGPT不會反轉單詞直接登上Reddit熱榜。

比如,讓它反轉lollipop這個詞,輸出的是pilollol,簡直是完全混亂的。

究其原因,主要還是大模型採用token來處理文本,這樣好處是能降低內存和時間複雜度。

但是,將單詞token化,明顯存在一個致命的問題,那就是模型很難學習到有意義的輸入,也就能理解為什麼ChatGPT不能理解單詞含義的原因了。

當讓它處理單詞反轉任務時,模型可能就是把每個token反轉過來,由此才出醜。

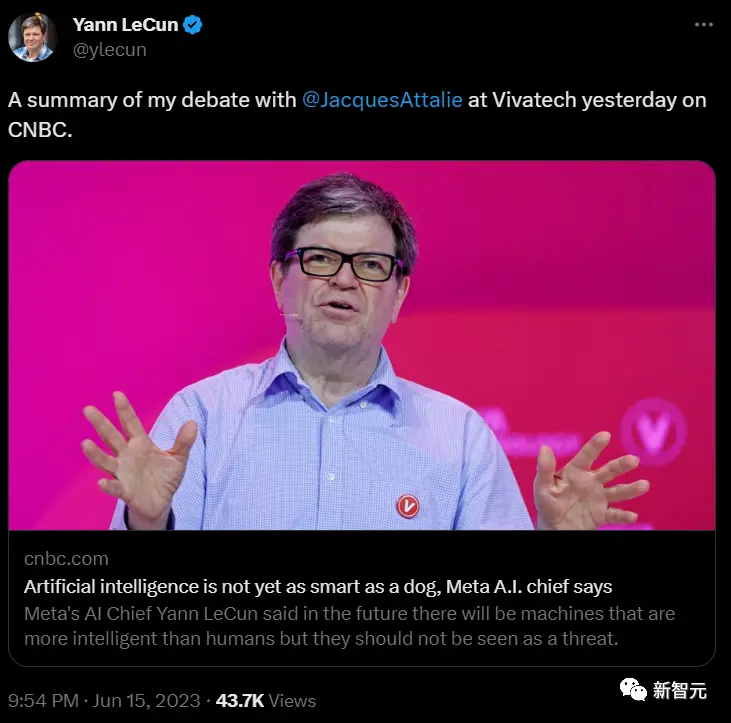

拋開ChatGPT,再廣泛地來講,一直以來圖靈獎的主Yann LeCun都把當前人工智能稱作,連貓狗都不如的AI。

一句話總結,「論聰明程度,ChatGPT可能連條狗都不如。」

LeCun表示,當前的AI系統,哪怕是ChatGPT,根本就不具備人類的智能水平。

在他看來,不必太過緊張,如今的AI智能水平遠遠沒到我們該擔憂的地步。

目前的生成式AI模型都是在LLM上訓練的,而這種只接受語言訓練的模型聰明不到哪去。這些模型的性能非常有限,它們對現實世界沒有任何理解。

由此,在一些人看來,OpenAI預測超級智能AI即將到來似乎很奇怪。

儘管如此,他們還是希望做好準備,能夠以先發制人的優勢,將AI滅絕人類的想法扼殺在搖籃中。

網友答疑

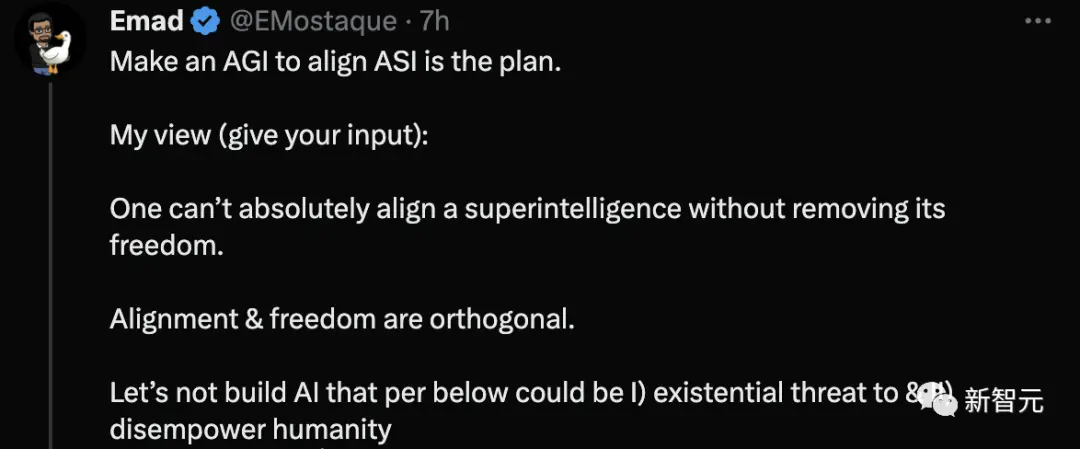

Stability AI的CEO表示,使AGI與ASI保持一致是我們的計劃。

我的觀點(提出你的意見):我們不可能在沒有拿走自由的情況下絕對地對齊一個超級智能體。對齊和自由是正交的。我們不要建造那些可能會對人類造成 I)生存威脅和 II)剝奪人類權力的人工智能。

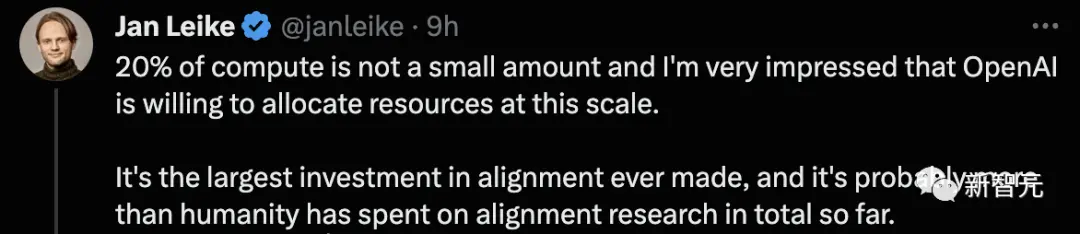

根據OpenAI博客介紹,未來要投入20%算力去做這件事,卻受到網友的質疑。

現在是時候有人考慮超級智能的安全問題了。但讓我們現實一點,20%的計算量真的能解決問題嗎?對於這樣一個巨大的問題,似乎只是杯水車薪。

OpenAI的對齊團隊領導人Jan Leike解釋道,

20%的計算量不是一個小數目,我對OpenAI願意以這種規模分配資源感到非常印象深刻。

這是有史以來對對齊的最大投資,它可能比人類到目前為止在對齊研究上的總花費還要多。

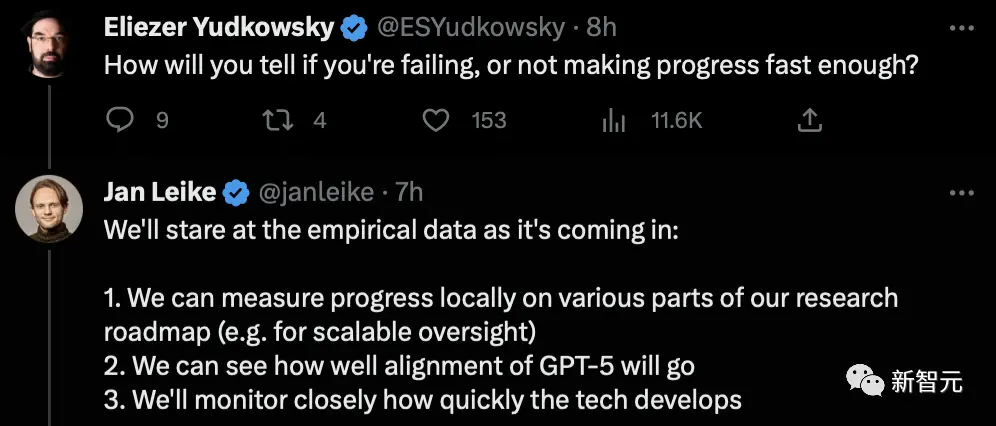

OpenAI將用4年的時間去完成這項任務,如何判斷是否失敗了,或者進展不夠快?

我們會關注即將到來的實證數據:

1.我們可以在本地衡量研究路線圖的各部分進展(例如,可擴展的監督)

2.我們可以看到GPT-5的對齊效果如何

3.我們將密切關注技術的發展速度

其實大多數人還是很想知道,OpenAI是不是在真正解決對齊研究之前,不會再研發超級AI了。

其實,Jan Leike的話中,早已透露出了GPT-5正在研發中。

許多人還是比較支持OpenAI這麼做的。

網友表示,希望機器的可解釋性是戰略的一部分,ASI不應該是一個黑盒子。如果我們有一天在不了解它是如何工作的情況下建立一個ASI,我們將有很大的麻煩。