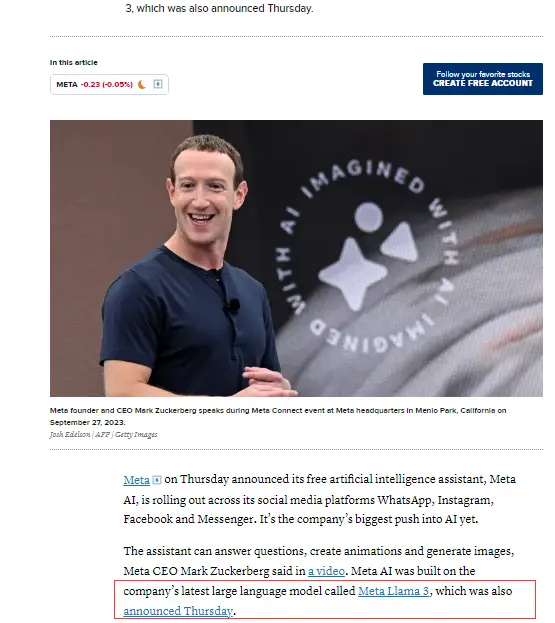

當地時間4月18日,AI領域迎來重磅消息,Meta正式發佈了人們等待已久的開源大模型Llama3。

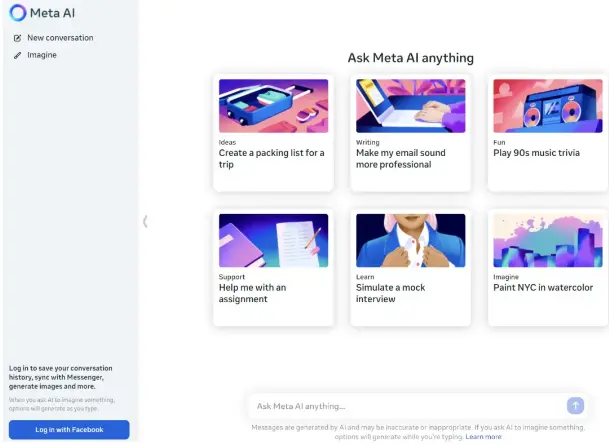

與此同時,Meta行政總裁扎克伯格宣佈:基於最新的Llama3模型,Meta的AI助手現在已經覆蓋Instagram、WhatsApp、Facebook等全系應用,並單獨開啟了網站。另外還有一個圖像生成器,可根據自然語言提示詞生成圖片。

Meta行政總裁馬克·扎克伯格在一段視頻中表示,該助理可以回答問題、製作動畫和生成圖像。

扎克伯格在 Facebook上發帖:Big AI news today

Meta行政總裁馬克·扎克伯格在視頻中表示:我們相信,Meta AI現在是你可以自由使用的最智能的人工智能助手。Meta AI內置於WhatsApp、Instagram、Facebook和Messenger應用程式的搜索框中,因此用戶可以輕鬆地提出可以通過新工具回答的問題。

扎克伯格表示,Meta提供的生成式 AI能力在免費產品中性能是最強大的。

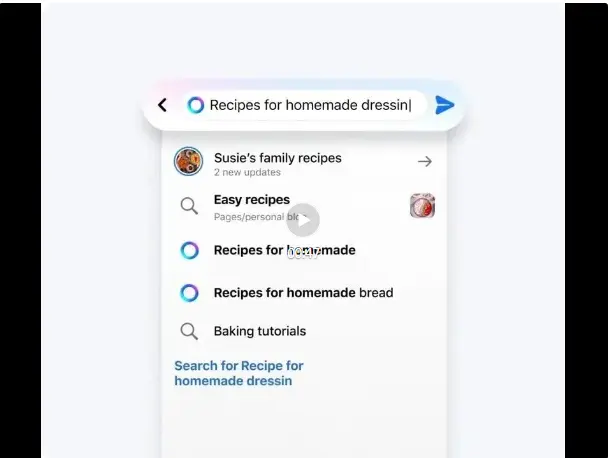

在 Facebook、Instagram、WhatsApp和 Messenger上,用戶現在可以藉助 Meta AI進行搜索,無需在應用程式之間切換:

當你瀏覽信息流的時候,還可以直接從帖子中向 Meta AI詢問更多信息:

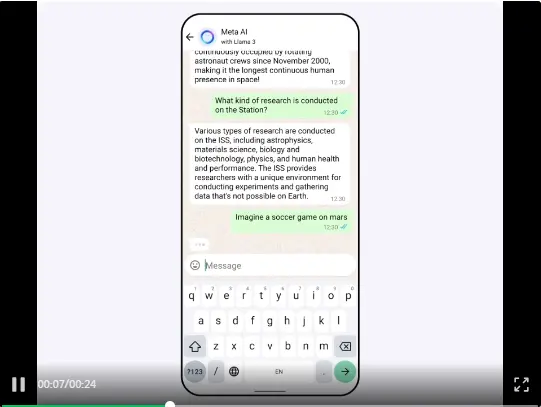

圖像生成器帶來的玩法更加有趣,Imagine功能帶來了從文本實時創建圖像。這一功能的測試版從今天開始在美國的 WhatsApp和 Meta AI網絡體驗上推出。

開始打字時,你會看到一個圖像出現,每多輸入幾個字母,圖像都會發生變化:

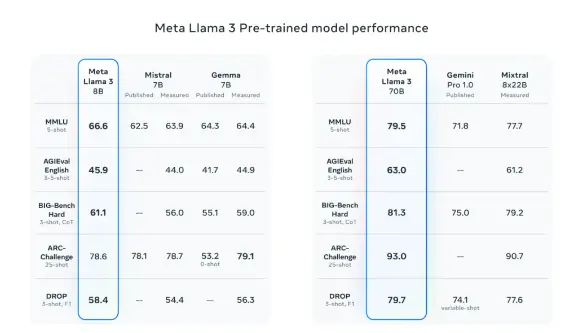

Meta表示,Llama3在多個關鍵的基準測試中性能優於業界先進同類模型,其在代碼生成等任務上實現了全面領先,能夠進行複雜的推理,可以更遵循指令,能夠可視化想法並解決很多微妙的問題。

Llama3的主要亮點包括:

基於超過15T token訓練,相當於Llama2數據集的7倍還多;

支持8K長文本,改進的tokenizer具有128K token的詞彙量,可實現更好的性能;

在大量重要基準中均具有最先進性能;

新能力範疇,包括增強的推理和代碼能力;

訓練效率比Llama2高3倍;

帶有Llama Guard2、Code Shield和CyberSec Eval2的新版信任和安全工具。

剛剛發佈的8B和70B版本Llama3模型已用於Meta AI助手,同時也面向開發者進行了開源,包括預訓練和微調版本。

最新發佈的8B和70B參數的Llama3模型可以說是Llama2的重大飛躍,由於預訓練和後訓練(Post-training)的改進,本次發佈的預訓練和指令微調模型是當今8B和70B參數規模中的最佳模型。與此同時,後訓練過程的改進大大降低了模型出錯率,進一步改善了一致性,並增加了模型響應的多樣性。

Llama3將數據和規模提升到新的高度。Meta表示,Llama3是在兩個定製的24K GPU集群上、基於超過15T token的數據上進行了訓練——相當於Llama2數據集的7倍還多,代碼數據相當於Llama2的4倍。從而產生了迄今為止最強大的Llama模型,Llama3支持8K上下文長度,是Llama2容量的兩倍。

此外,Meta還開發了一套新的高質量人類評估數據集。該評估集包含1800個提示,涵蓋12個關鍵用例:尋求建議、頭腦風暴、分類、封閉式問答、編碼、創意寫作、提取、塑造角色、開放式問答、推理、重寫和總結。為了防止Llama3在此評估集上出現過度擬合,Meta表示他們自己的團隊也無法訪問該數據集。下圖顯示了針對Claude Sonnet、Mistral Medium和GPT-3.5對這些類別和提示進行人工評估的匯總結果。

下圖是 Llama3預訓練模型和其他同等規模模型的比較,前者表現出 SOTA水平。

為了訓練最好的語言模型,管理大型、高質量的訓練數據集至關重要。Meta在預訓練數據上投入了大量成本。Llama3使用超過15T的token進行了預訓練,這些token都是從公開來源收集的。總體上講,Llama3的訓練數據集是Llama2使用的數據集的七倍多,並且包含四倍多的代碼。為了為即將到來的多語言用例做好準備,超過5%的Llama3預訓練數據集由涵蓋30多種語言的高質量非英語數據組成。但是,Llama3在這些語言上的性能水平預計不會與英語相同。

為了確保Llama3接受最高質量數據的訓練,研究團隊開發了一系列數據過濾pipeline,包括使用啟發式過濾器(filter)、NSFW過濾器、語義重複數據刪除方法和文本分類器來預測數據質量。

研究團隊發現前幾代Llama非常擅長識別高質量數據,因此Meta使用Llama2為給Llama3提供支持的文本質量分類器生成訓練數據。

研究團隊還進行了廣泛的實驗,以評估出在最終預訓練數據集中不同來源數據的最佳混合方式,最終確保Llama3在各種用例(包括日常問題、STEM、編碼、歷史知識等)中表現良好。

Meta表示,最大的Llama3參數超過400B,雖然這些機型仍在訓練中,但在接下來的幾個月中也將陸續發佈,新功能包括多模態、多語言對話能力、更長的上下文窗口以及更強的整體能力。

Meta希望Llama3能趕上OpenAI的GPT-4。不過知情人士透露,因為研究人員尚未開始對Llama3進行微調,所以尚未決定Llama3是否將是多模態模型。微調是開發人員為現有模型提供額外數據的過程,以便它可以學習新信息或任務。較大的模型通常會提供更高質量的答覆,而較小的模型往往會更快的提供答覆。有消息稱,正式版的Llama3將會在今年7月正式推出。

Meta還宣佈與Alphabet的谷歌建立新的合作夥伴關係,在助手的答覆中包括實時搜索結果,作為與微軟必應現有合作的補充。隨着此次更新,Meta AI助手正在擴展到美國以外的十多個市場,包括澳大利亞、加拿大、新加坡、尼日利亞和巴基斯坦。考克斯說,Meta「仍在努力以正確的方式在歐洲做到這一點」。歐洲的私隱規定更加嚴格,即將出台的人工智能法案也準備提出披露模型訓練數據等要求。