這項新研究支持有限容量的設備運行內存2倍大小的LLM,GPU的推理速度可以提升數十倍。媒體稱,蘋果將生成式AI集成到iOS18的計劃或將加快推進。

AI iPhone要來了?

據媒體報道,近日,蘋果發佈了一篇論文,介紹了一種可以再超出可用DRAM容量的設備上運行LLM(大語言模型)的方法。

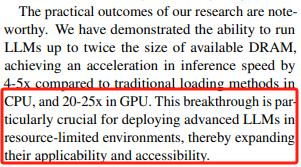

通過大幅提高內存使用效率,這項新研究支持有限容量的設備運行內存2倍大小的LLM,GPU的推理速度可以提升數十倍。

論文稱,LLM密集的計算量和內存要求對於DRAM容量來說是一大挑戰,該論文構建了一個以閃存為基礎的推理成本模型,將在兩個關鍵領域進行優化:減少從閃存中傳輸的數據量、更多更流暢地讀取數據塊。

這意味着,該項突破性研究擴大了LLM適用性和可及性,蘋果將生成式AI集成到iOS18的計劃或將加快推進。

LLM能在手機上運行了?

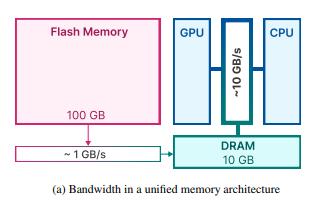

一般來說,DRAM就是我們常說的「內存」,而flash(閃存)指的是硬盤。

運算數據時,CPU通常會以DRAM為「中間橋樑」,把硬盤中的數據複製到內存中來,再在內存中做數據處理,這樣速度可以提升至數百萬倍。

但在容量上,DRAM相較於硬盤要小一個數量級。而LLM運行時,需要同時處理的數據量龐大,對容量有限的設備來說構成了極大的挑戰。

但這篇論文提出的新框架似乎發現了突破點。該框架旨在將模型參數存儲在閃存中,在需要的時候再將數據調入DRAM,解決了LLM運行時數據處理量超過DRAM可用容量的難題。

具體而言,蘋果主要運用了兩種技術:

(1)「窗口化」技術:重複使用此前激活過的神經元,以此減少數據傳輸;

(2)「行列捆綁」技術:針對閃存的數據特徵,定製訪問數據塊的順序,從而增加從閃存讀取的數據塊大小。

論文提及,一個70億參數的模型就需要超過14GB的內存來加載半精度浮點格式的參數,超過了大多數網絡端點的承受能力。但是通過該框架,能夠實現最小化數據傳輸並最大化閃存吞吐量,從而減少數據負載、提高內存使用效率。

研究結果顯示,與傳統的加載方法相比,該框架支持DRAM兩倍大小的模型,在CPU和GPU中推理速度可分別提升4-5倍、20-25倍。研究團隊在文末總結道:

「這項突破性技術對於在資源有限的環境中部署先進的LLM尤為重要,從而擴大LLM適用性和可及性。」

手機巨頭們瞄準了AI

在AI潮下,各大手機製造紛紛開始佈局「人工智能+手機」。

據此前市場消息,蘋果將在其iOS18中引入AI,主要用於Siri和通訊應用程式的智能問答、生成語句等功能,此外,蘋果還在探索AI在Apple Music、Page、Keynote和Xcode等應用中的潛能。

三星於11月初推出其生成式AI模型Samsung Gauss,報道稱該模型將納入即將於2024年初發佈的Galaxy S24系列手機中,三星旗下筆記本電腦、平板電腦也有可能集成該模型。

谷歌的雙子星大模型(Gemini)也將集成到谷歌旗下產品,11月,谷歌官宣Gemini1.0將在谷歌產品中逐步推出;Gemini Pro將集成到Bard中以進行高級推理和規劃;Gemini Nano將為Pixel8 Pro智能手機的功能提供支持。