要說今年「科技春晚」CES上最吸引眼球的是什麼,智能車當屬其一。

畢竟大模型一上車,智能座艙都捲成醬嬸了:

讓車上的數字助手幫忙記錄約飯日程,Ta能直接幫你把餐廳也給預定了。

規劃路線這種事兒也變得充滿巧思,數字助手會根據你的習慣,主動問你:「路上買杯咖啡不?」

智能車上下游廠商紛紛秀出肌肉,也難怪不少前線參展的胖友們感嘆:CES能當車展逛了。

事實上,隨着大模型落地應用的重點從雲側走向端側,不僅是手機廠商紛紛捲起端側大模型,大模型上車也已成為關注焦點之一:

智能車是現今最重要的智能移動終端之一,而大模型被認為是AI規模化應用的關鍵。

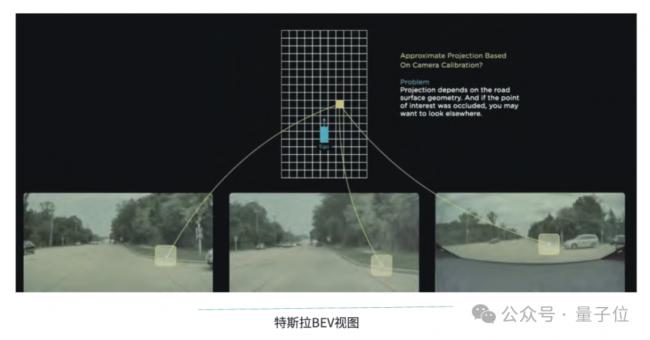

不止是基於大模型、生成式AI能力構建智能座艙,由特斯拉而引起熱議的端到端自動駕駛方案,背後也正代表着通過大模型串聯感知、預測、規劃所有模塊的全新技術趨勢。

△驍龍座艙平台效果展示

△驍龍座艙平台效果展示

也就是說,在大模型重構一切掀起的「模力時代」中,從智能座艙到自動駕駛,「汽車機械人」的真正實現,正在全方位圍繞大模型展開。

那麼,問題來了——

智能車真的需要大模型嗎?

前文已經說到,大模型上車的兩種最受關注的趨勢,其一圍繞自動駕駛,其二聚焦智能座艙。

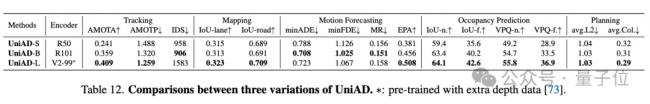

自動駕駛方面,隨着CVPR2023最佳論文頒給自動駕駛大模型,一種行業共識浮出水面:

端到端自動駕駛是行業的未來,而新的突破將以大模型技術為基礎。

△CVPR2023最佳論文

有別於傳統上更多基於規則的自動駕駛算法,端到端模型能夠直接基於傳感器輸入(如攝像頭數據),學習如何控制輸出,無需人為設計複雜的中間表示。

舉個例子,在端到端自動駕駛方案中,想要讓模型學會不闖紅燈,無需設計規則,只要多用高質量的交通信號燈視頻訓練它就行。

這也就意味着,端到端模型能夠更好地處理複雜的交通場景:相比於對手寫規則的依賴,此類模型可以針對實際場景進行推理,更能夠解決corner case帶來的應用落地問題。

量子位智庫在《2023年度十大前沿科技趨勢報告》中指出,端到端自動駕駛技術以全部模塊神經網絡化為特徵,對規則的依賴度低,具備智能湧現能力和跨場景應用潛力。

而在CVPR2023最佳論文《Planning-oriented Autonomous Driving》中,研究人員通過實驗證明,骨幹網絡的增大能夠帶來感知分數的提升,這可能進一步改善模型的預測和規劃性能。

也就是說,更大的模型能夠提供更豐富的特徵表示和更複雜的任務處理能力,能夠更好地支持自動駕駛場景中複雜的數據處理和決策制定。

如果說大模型驅動的自動駕駛還是探索進行時,生成式AI與智能座艙的結合,則已經更快一步有了具體落地案例。

在今年的CES上就可見一斑。

比如吉利銀河E8,就已大模型上車,實現了車上的影音娛樂和AI交互的個性化:基於文生圖大模型,秒級生成私人定製款專屬壁紙、精準推薦音樂還能基於音樂意境生成風格化壁紙、AI數字精靈具備「人設」更加擬人……

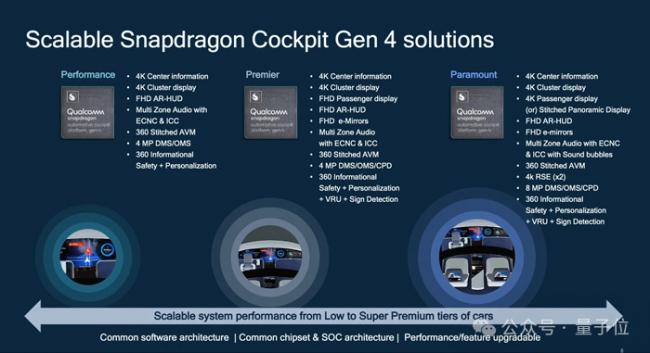

高通的驍龍數字底盤概念車,更直觀展現出了邊緣側生成式AI的高效用例。

比如儀錶盤上出現了一個警示燈,不必研究用戶手冊,直接向數字助手提問就能立刻得到答案。AI甚至還能幫助你當場預約維修。

△youtube@HotHardware

關鍵是,部署在車端的大模型,即終端側AI的模式,在結合本地數據提供更加個性化的座艙服務的同時,能夠保護用戶數據「足不出車」。這既保障了用戶的私隱安全,也緩解了雲端處理帶來的時延問題。

另外,對端側算力的充分利用也能大大緩解用戶規模化增長給雲端算力帶來的成本壓力。

不難看出,對於自動駕駛領域而言,大模型的技術浪潮,帶來了突破當前技術瓶頸的新路徑。因此也不乏業內人士給出這樣的判斷:真正要在通用場景下實現L4、L5級自動駕駛,大模型不可或缺。

值得關注的是,儘管雲側基礎大模型及其應用一年來進展飛速,但大模型上車,仍然存在不小的挑戰。

其一,是數據問題。相比於互聯網的海量數據,自動駕駛領域本身數據量要小得多,並且對於訓練端到端模型而言,來自優秀人類駕駛員的高質量數據更為關鍵。

其二,是算力問題。無論是智能駕駛中的路況實時推理,還是智能座艙中的用戶意圖理解和功能調度,都對端側算力有着更高的需求。

其三,還有安全性問題。這一方面涉及到端到端自動駕駛模型的可解釋性,另一方面,是端雲結合過程中,如何確保用戶私隱數據不泄露的問題。

而從硬件的視角來看,這些問題,實際上都對車載晶片提出了更高的要求。

「模力時代」,智能車需要什麼樣的車芯?

如果說驍龍8155(第三代旗艦級驍龍座艙平台)在過去幾年中已經成為座艙是否智能的事實衡量標準之一,那麼,在CES「車展」上頻頻出現的另一個關鍵詞,已經透露出「模力時代」智能車新的競逐方向——驍龍8295(第四代至尊級驍龍座艙平台)。

從國產造車新勢力,到奔馳寶馬,CES上亮相的最新量產車上,驍龍8295已經成為新的標配。

△搭載驍龍數字底盤解決方案的寶馬i7

在大模型上車的最新趨勢里,車芯最新的進化方向是什麼樣的,不妨就以驍龍8295為例,具體拆解來看。

驍龍8295採用5nm工藝製程打造。算力方面,其CPU算力達到230K DMIPS,是驍龍8155的8倍;GPU則可實現每秒2.9萬億次單精度浮點運算(2.9TFLOPS)或每秒5.8萬次半精度浮點運算(5.8TFLOPS),相較於8155,整體性能提升2倍,3D渲染性能提升3倍,能同時帶動車內11塊屏幕,遠超市面上其他車機晶片。

更關鍵的是,驍龍8295搭載雙核NPU,AI算力從8155的4TOPS直接躍升至30TOPS。

這樣的參數性能,放在車規級晶片上,可以說是一騎絕塵。而反映到功能上,大模型、多模態交互、離線語音,甚至是艙泊一體、駕艙一體,都有了實現的基礎。

以搭載了驍龍8295的極越01為例,雲端的語音識別算法模型直接放在車端,實時響應時間能從1.5秒縮短到700毫秒。

除了常規自主泊車,還能在車外語音控制車輛實現自主泊車。

車內,在驍龍8295的支持下,極越01能實現對不同說話人的識別,也就是支持多人同時語音功能。配合離線語音庫,即使沒有網絡連接,也能實現全功能語音識別。

並且車內的智能交互,現在也不僅僅停留在語音層面,配合眼神、動作的多模態交互,現在也可以在車上實現。比如,想要打開車上的某一扇窗戶,不用詳細說明,只要一句「打開窗戶」再配合視線,車上AI就能秒懂車主心意。

值得一提的是,驍龍8295作為可擴展自動駕駛SoC平台,擁有廣泛的軟件生態系統,包括視覺感知、泊車和駕駛員檢測軟件棧等等。

對於車企而言,這意味着在驍龍座艙平台的基礎上整「花活」更加方便快捷。

而站在消費者的角度,座艙內智能化體驗的升級,以上所述也僅僅是個開始。

終端側AI是AI規模化關鍵大模型帶來的變革,核心是人機交互方式的變革。

而智能車作為被給予厚望的「智能空間」,自然而然成為這場重構一切的技術變革風暴中不容忽視的一環。

智能車的「ChatGPT時刻」具體何時會到來,還沒有人能夠準確地預判。但至少在軟硬件準備上,以高通為代表的玩家,已經率先一步做好了迎接爆發的準備。

事實上,這種逐漸聚焦到終端的對新「ChatGPT時刻」的期待,在2024年開端的這場CES上,可以說是無處不在。智能車備受矚目,但遠非全部。

從爆火的AI掌機Rabbit R1,到AI PC,再到AR/VR和具身智能機械人,AI與終端的結合,幾乎已經蔓延到CES會場的每一個角落。

「模力時代」新一階段的變革走向,也在其中越發顯現:大模型/生成式AI技術落地到端側,是新一輪AI機遇爆發的關鍵。

對此,高通公司總裁兼CEO安蒙在CES主題演講中談到:

生成式AI的發展,正在從第一階段走向第二階段。當前,整個行業已經將生成式AI在處理器中落地,下一步將是使用場景和應用的開發。

歸結原因,核心其實是,數據在哪裏,AI推理就應該在哪裏進行。

一方面,雲計算推理成本正隨着大模型應用用戶數量的增加和模型參數規模的增大而急劇增加,需要充分利用端側算力來平衡成本。另一方面,只有當終端就能運行AI大模型用例時,個人數據才能在受到保護的前提下被充分運用,實現真正個性化的大模型應用。

總而言之,2024年一開年,「模力時代」終端變革的一角,已經進一步向大眾揭開。

可以預見的是,變革的風暴不會就此停滯,更多的智能變化,或許就將在這一年中,通過智能終端,離你我的生活更進一步。