Claude反向開卷GPT-4,卷對了方向?

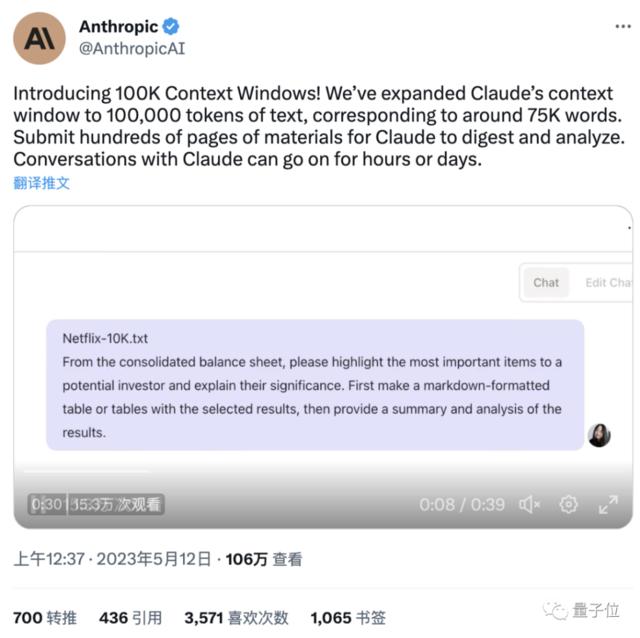

號稱ChatGPT「最強競爭對手」的Claude,今天迎來史詩級更新——

模型記憶力原地起飛,現在1分鐘看完一本數萬字的小說,已經不在話下。

消息一出,評論區直接炸了,網友們蜂擁而至,「woc連連」:

瘋了瘋了!

事情進展得太快了,又是為人類擔心的一天!

原來,這次更新,將模型的上下文窗口token數提到了足足10萬,相當於7.5萬個單詞!

這意味着,大模型「記性」不好的缺陷現在得到補強,我們可以直接丟給它上百頁上萬字的材料,比如財報、技術文檔甚至是一本書。

而它都能在一分鐘之內幫你分析總結完畢!

要知道,之前市面上幾乎所有AI聊天機器一次都只能讀取有限數量的文本,理解長資料里的上下文關係非常災難。

而我們人類自己去處理大篇幅的文本又太慢了,比如光是要讀完10萬token的材料,就需要大約5個多小時,更別提還要花更多的時間去理解去消化才能進行總結。

現在,Claude直接一把搞定。

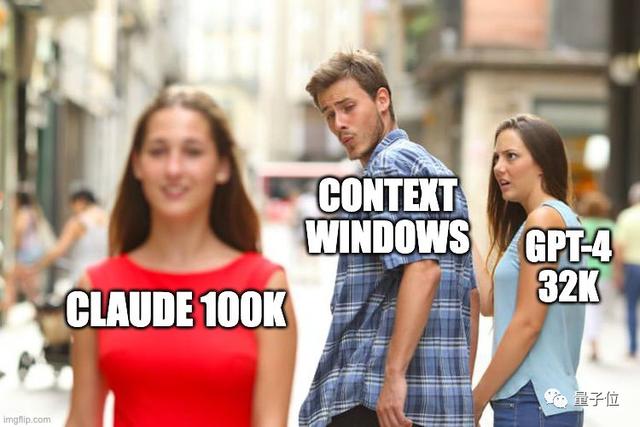

這波,簡直是「五雷轟頂」、「反向開卷」GPT-4,因為,剛剛後者也不過才做到3.2萬token。

所以,一次性比GPT-4多出3倍的處理量,Claude效果提升究竟如何?

Claude重磅更新:一次記憶10萬token

據Anthropic官方介紹,升級後的Claude-100k版本,對話和任務處理能力雙雙得到極大提升。

一方面,是「一次性可處理文本量」的增加,直接拓寬了Claude的可從事崗位類型。

之前,大模型最多用來處理個幾十頁的文檔。

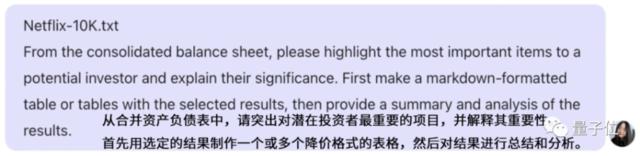

現在,Claude已經能速讀公司財報年報、技術開發文檔、識別法律文件中的風險、閱讀上百頁研究論文、乃至於處理整個代碼庫中的數據。

最關鍵的是,它不僅能通讀全文總結其中的要點,還能進一步完成具體任務,如寫代碼、整理表格等。

例如,快速理解幾百頁的開發文檔,並根據文檔開發應用程式demo。

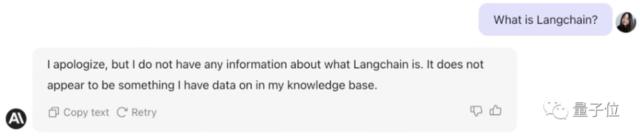

以Claude之前沒見過的一項新技術LangChain作為示例:

當交給它一個240頁的LangChain API報告後,要求它快速給出一個LangChain的demo演示:

幾乎沒用多少時間,Claude就快速給出了一個基於LangChain開發的應用程式demo:

又例如,甩給它一個漫長但又不得不聽的5小時知識播客:

它不僅能將重點轉成文字提取出來,還能快速整理表格,對觀點進行分析:

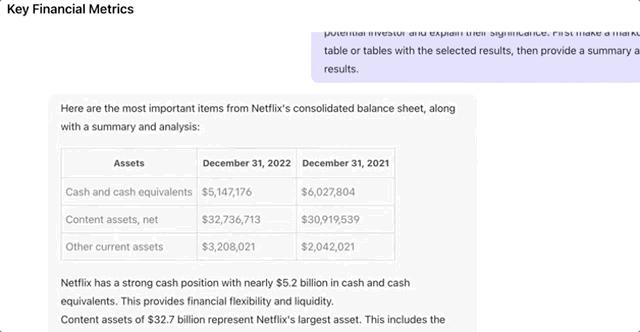

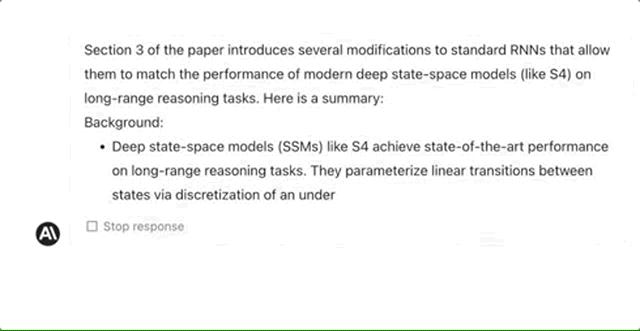

難度增大一點,30頁的研究論文也能很好地處理,甚至能準確指定它整理某一章節的某一段落:

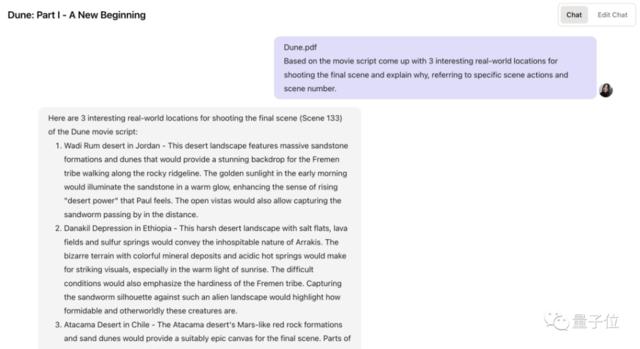

除此之外,還能幫導演處理劇本選址一類的問題。如給出《沙丘》的電影腳本,問Claude最適合拍攝的地點,它很快就能給出幾個對應的參考地址:

最後,官方還給出了一個《了不起的蓋茨比》案例,雖然沒有demo演示。

他們將這篇餵給Claude後,替換了其中一個角色Mr. Carraway,把他的角色變成「Anthropic里的一位工程師」,再交給Claude閱讀,讓它找不同。

幾乎只用22秒鐘,Claude就讀完這本書,並發現了Mr. Carraway的「不同身份」。

另一方面則是「記憶力」的增加,帶來了對話題掌控度的提升、以及聊天能力的提升。

此前大模型經常會出現「聊着聊着忘了話題」的情況,對話窗口總字數超過幾千字後,開始胡言亂語。

舉個栗子,如果你用大量提示詞設置了一個ChatGPT版貓娘,那麼它開始聊天后,可能幾個小時就忘記了自己和你說過的話,開始表現出一些「出軌」的跡象(手動狗頭)

但現在,擁有一次10萬+個token記憶力的Claude,則不太可能出現這種情況,反而能牢牢記住和你聊過的話題,連續交談上好幾天。

那麼,目前我們能通過什麼方式用上最新版Claude呢?

API和網頁版均已上線

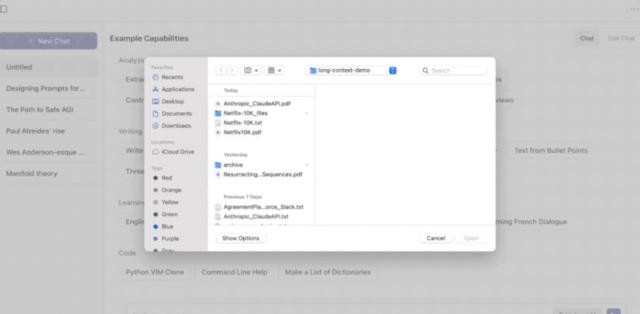

Anthropic先是宣佈推出了Claude-100k的API版本,之後又火速上線了網頁端。

所以無論你是用網頁端還是用API,目前都已經可以直接體驗這個擁有「超長記憶力」的Claude版本。

很快啊,已經有網友迫不及待玩上了。

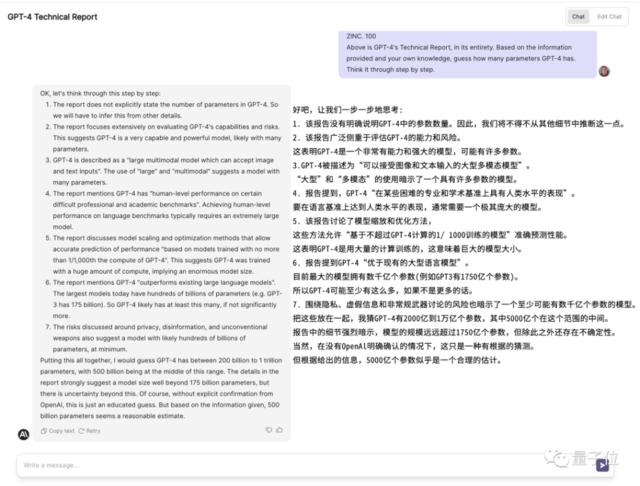

像OthersideAI的CEO Matt Shumer,就試用了一下網頁端的Claude-100k總結技術報告的效果。

他先測了波Claude-9k的效果,發現它面對長達上百頁的GPT-4技術報告,還是會出現「幻覺」;隨後測試新版Claude-100k,發現它給出了有理有據的估計:

GPT-4的參數量級大約在5000億左右!

這是它的推測過程:

不知道這波OpenAI的奧特曼會不會出來闢謠(手動狗頭)。

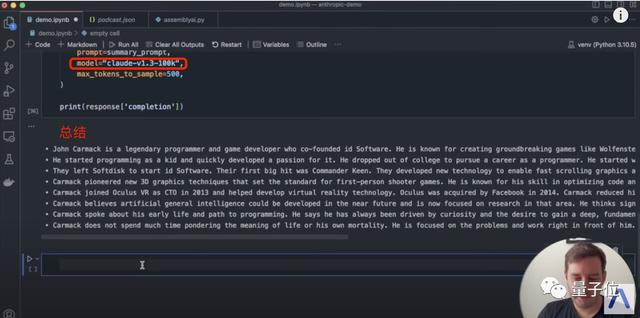

還有一位Assembly AI的老哥,測試了一下Claude-100k的API版本。

在視頻演示中,他用Claude-100k總結了一下Lex Friedman的5小時長播客(內容與John Carmack有關),效果看起來也非常不錯:

但無論是網頁版還是API,都還不是我們能免註冊直接試玩的版本。

之前我們說的不用註冊、不用申請、不用「騷操作」就能玩、體驗也很不錯的是slack端,它的添加方法我們在之前的文章中介紹過,非常簡單。

遺憾的是,目前它還是Claude-9k「體驗版」。

所以,總結一下就是,這個Claude-100k的版本:

可以用API的方式體驗,不過不是免費的;

網頁版也行,但需要你有試用資格,沒有就去申請,等一等;

Slack端還不行,只是個體驗版。

反向開卷GPT-4,網友:卷對了方向

昨天,谷歌剛剛在I/O大會上宣佈了數項重大更新,包括:

重構谷歌搜索、開啟AI對話

發佈大模型PaLM2

全面開放Bard,不用排隊直接玩

……

這被視作針對微軟和OpenAI的一系列反擊。

現在,來自Anthropic的Claude緊隨其後,發佈如此重大更新,直接反向開卷GPT-4——

有網友評價:

Claude卷對了方向。

確實,目前大部分語言模型普遍都只能處理2-8k的token量,大家都在苦苦追尋提高模型記憶力的辦法。

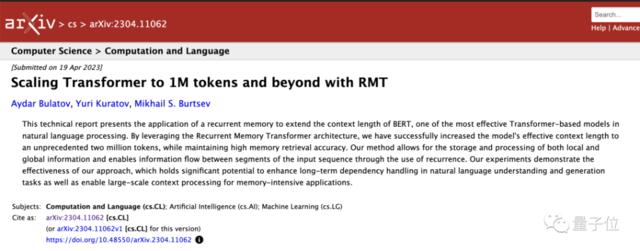

比如上個月那篇可將Transformer token上限擴展到100萬甚至200萬的論文就引起了非常大的關注,不過網友測試效果似乎不太理想。

現在,Claude直接「業內第一人」宣佈做到了100k,並拿出來給大家用,很難不讓人稱讚。

除此之外,還有網友「站得更高」,稱:

資本主義之間的競爭果然很美妙。

言外之意,卷得好啊卷得妙。沒有巨頭和各垂直企業之間的你爭我搶,我們哪能在短短兩天之間又目睹了如此多和重大的進展呢?

誒,不過話說回來,鑑於Anthropic是由當初不滿意OpenAI與微軟走得太近的幾位前員工創立,而谷歌也斥資3億美元投資了這家公司。

大膽猜測:

這次兩人前後腳的「一唱一和」,是不是提前商量好的?